Temat opisywany w poprzednim wydaniu PIONIER NEWSa wzbudził niemałe zainteresowanie i postanowiliśmy opisać szczegóły techniczne rozwiązań użytych w tej sieci.

Architektura i ogólna charakterystyka SCinet

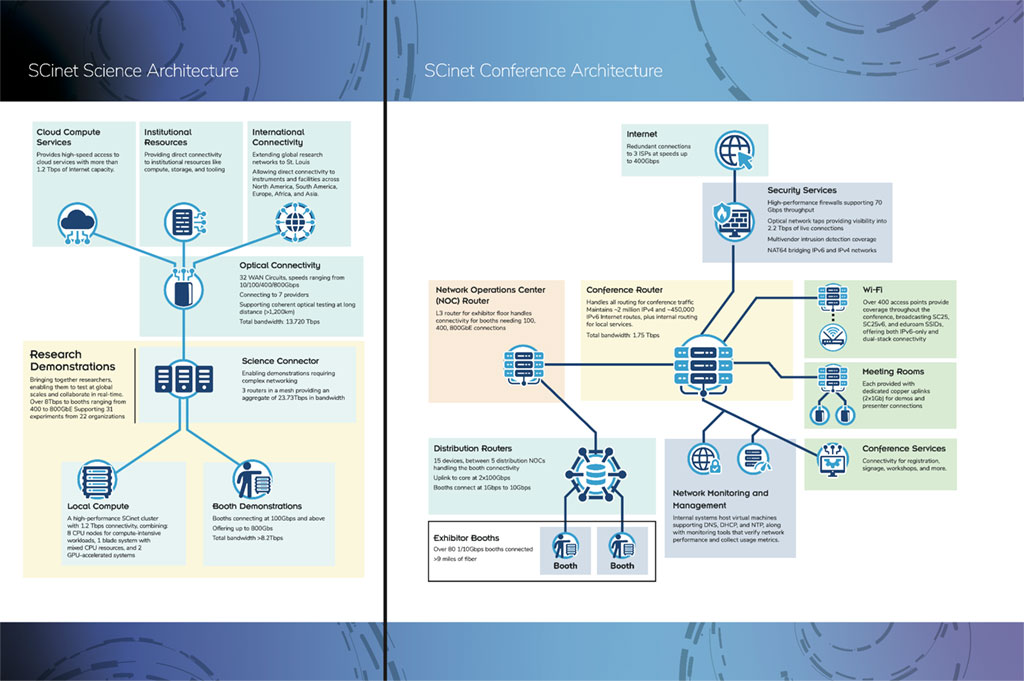

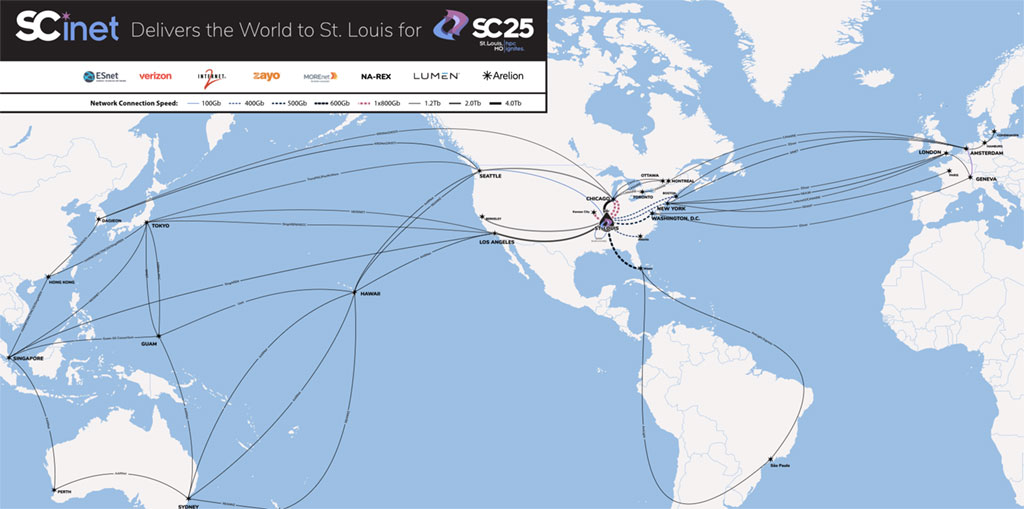

Powyższa grafika przedstawia schemat sieci. Jak można zauważyć, sieć SCinet to w zasadzie dwie sieci:

- Conference Network – zapewniająca przewodowy i bezprzewodowy dostęp do Internetu dla uczestników i wystawców — zarówno obecnych na miejscu, jak i zdalnych.

- Science Network – sieć badawcza wspierająca Network Research Exhibition (NRE), eksperymentalne projekty sieciowe SCinet oraz duże demonstracje technologiczne.

W tegorocznej edycji schemat architektury sieci został świadomie uproszczony w porównaniu do lat ubiegłych. Decyzja ta była konsekwencją dynamicznych zmian w dostępności i konfiguracji sprzętu, które — jak to często bywa w tego typu przedsięwzięciach — następowały na bardzo późnym etapie przygotowań. W efekcie konieczne było odejście od dosłownego odwzorowania infrastruktury na rzecz bardziej koncepcyjnego ujęcia architektury. W praktyce pełny i ostateczny kształt sieci staje się znany dopiero po zakończeniu wszystkich etapów wdrożenia oraz przezwyciężeniu napotkanych po drodze wyzwań.

Główna część sieci SCinet (NOC) jest zazwyczaj zlokalizowana w centralnej części Exhibition Floor. Jest to 8 połączonych ze sobą szaf rack ze sprzętem sieciowym i serwerami, pogrupowanych według pełnionej funkcji. Dodatkowo budowanych jest kilka lokalizacji DNOC, czyli punktów dystrybucyjnych, z których wyprowadzane są połączenia dla wystawców. Możemy ich podzielić na dwie grupy:

- Użytkownicy “Conference network” korzystają z konferencyjnej sieci WiFi lub łączy o prędkości 1 lub 10Gbit doprowadzonych światłowodem do ich stoiska. Wraz z łączem dostają publiczne adresy IPv4 oraz IPv6. Ci właśnie wystawcy są podłączeni do rozlokowanych po całej wystawie punktów dystrybucyjnych DNOC.

- Użytkownicy “Science Network” korzystają z sieci o prędkości 100Gbit lub szybszej, najczęściej są to wystawcy uczestniczący w NRE, czyli Network Research Exhibition. Duża ich część w tym roku znajdowała się blisko głównej sceny i ich łącza światłowodowe były podwieszone pod sufitem i poprowadzone bezpośrednio do NOC, w niektórych przypadkach były one krosowane przez DNOC.

Sieć SCinet Science

Sieć SCinet Science (SCN) jest nastawiona na dostarczenie zasobów sieciowych koniecznych do przeprowadzenia doświadczeń sieciowych. W 2026 roku było to 31 eksperymentów dotyczących, m.in..: wykonywania dalekich transferów danych, optymalizacji połączeń i protokołów, automatyzacji i orkiestracji sieci. Sieć SCN daje zespołom badawczym dostęp do bardzo wydajnej, nowoczesnej infrastruktury sieciowej oraz połączeń o ogromnej przepustowości. Umożliwia testowanie i sprawdzanie nowych rozwiązań sieciowych w realnych warunkach, w skali zbliżonej do produkcyjnej, czego nie da się zrobić w typowych laboratoriach. Jednocześnie sprzyja współpracy między zespołami z różnych krajów i pomaga przenosić sprawdzone rozwiązania do sieci produkcyjnych.

W tym roku do budowy sieci wykorzystano m.in.:

- Juniper PTX10002-36QDD

- Nokia SR-1se

- Ciena 8190

- Arista DCS-7060X6-64PE

- Nokia 7750 SR-1X-48D QSFPDD-800ge

Są to wysokowydajne routery i przełączniki różnych producentów, przeznaczone do pracy z bardzo dużymi przepustowościami. Wykorzystane urządzenia umożliwiały obsługę łączy 400G i 800G oraz nowoczesnych usług sieciowych. Zróżnicowany sprzęt pozwolił na testowanie interoperacyjności i realną pracę w środowisku wielu producentów. W tym roku sieć SCN była oparta na technologii EVPN-VXLAN, co w tak zróżnicowanym środowisku okazało się dużym wyzwaniem.

Lista zrealizowanych doświadczeń NRE: https://sc25.supercomputing.org/scinet/network-research-exhibition/accepted-nre-demos/

Sieć SCinet Conference

SCinet Conference jest siecią dostarczającą usługi sieciowe ponad 16500 uczestnikom konferencji SuperComputing! Jest to rozbudowana sieć składająca się z:

- Routerów i switchy szkieletowych

- Routerów i switchy dystrybucyjnych

- Sieci Wi-Fi (450 AP)

- Sieci Edge (145 switchy)

- Serwerów i oprogramowania do monitoringu sieci

- Serwerów do świadczenia usług konferencyjnych (rejestracja, streaming video)

Sieć została zbudowana z użyciem Junipera MX304 oraz połączeń 100G i 400G do operatorów telekomunikacyjnych. Sieć dystrybucyjna to nowoczesne urządzenia sieciowe: Nokia 7220, Aruba 8360 i 6300M, Arista DCS-7280 i Juniper QFX5120.

WAN

Niesamowitą bazę do budowy sieci SCinet stanowi rozległa sieć WAN. W roku 2026 było 32 łącza zakończone w St. Louis, w znakomitej większości były to łącza 400G! Wykonano również testowe połączenie z użyciem modułów 800G Ciena WL6n na odległości 1050 km. Łączna przepustowość łączy wyniosła 13,72 Tbps, a dzięki zastosowaniu technologii DWDM wystarczyło do tego jedynie 12 par włókien światłowodowych.

Wykonanie wszystkich połączeń jest ciekawym wyzwaniem technicznym, ale również organizacyjnym, ponieważ wymaga współpracy z wieloma operatorami telekomunikacyjnymi (MOREnet, ESnet, Internet2, Lumen, Verizon, Zayo, Arelion, NA-REX).

Podobnie jak w innych obszarach sieci SCinet, do obsługi połączeń WAN stosowany jest sprzęt różnych producentów – Ciena, Infinera, Cisco, Nokia, Arista. Poza urządzeniami DWDM w sieci zastosowano też switche światłowodowe (Polatis 192×192 oraz DiCon 96×96) automatyzujące fizyczne przełączanie tras światłowodowych.

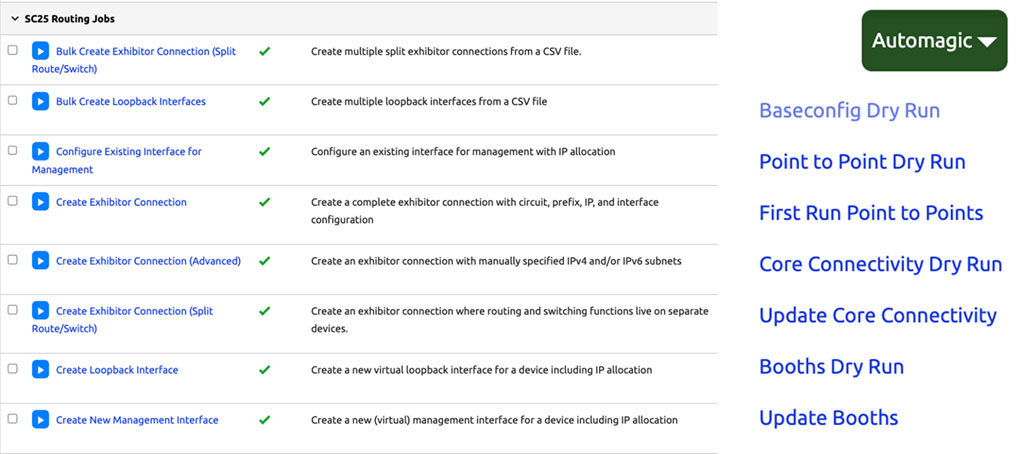

Automatyzacja

Automatyzacja zadań związanych z konfiguracją sieci od wielu lat jest istotnym obszarem działalności zespołów w SCinet. W tym roku zadania zostały zintegrowane w ramach dedykowanego zespołu, który wykonał infrastrukturę automatyzacji sieci składającą się z:

- Nautobot – podstawowe źródło informacji o sieci (Source of Truth)

- Cisco NSO – platforma do orkiestracji

Automatyzacja sieci SCinet wiąże się z wieloma trudnościami, m.in. duża liczba producentów stosowanych urządzeń, częste zmiany usług dostępnych użytkownikom i krótki czas na testowanie w rzeczywistych warunkach. Stosowanie automatyzacji wymusza jednak szczegółowe planowanie sieci i stosowanie Source of Truth, co w rezultacie usprawnia całość procesu.

Fiber

Sieć o tak wysokich przepustowościach jest wykonana z użyciem światłowodów. Wykonaniem sieci zajmuje się dedykowany zespół “Fiber” odpowiedzialny za planowanie tras, ułożenie okablowania i przetestowanie połączeń. W tym roku było to łącznie 17 mil światłowodów! Stałą częścią pracy zespołu jest usuwanie awarii. W tak dynamicznym środowisku, jakim jest hala wystawowa w czasie przygotowywania konferencji, łatwo o uszkodzenie kabla, co wiąże się potem z koniecznością lokalizacji uszkodzenia, wymiany fragmentu i spawania.

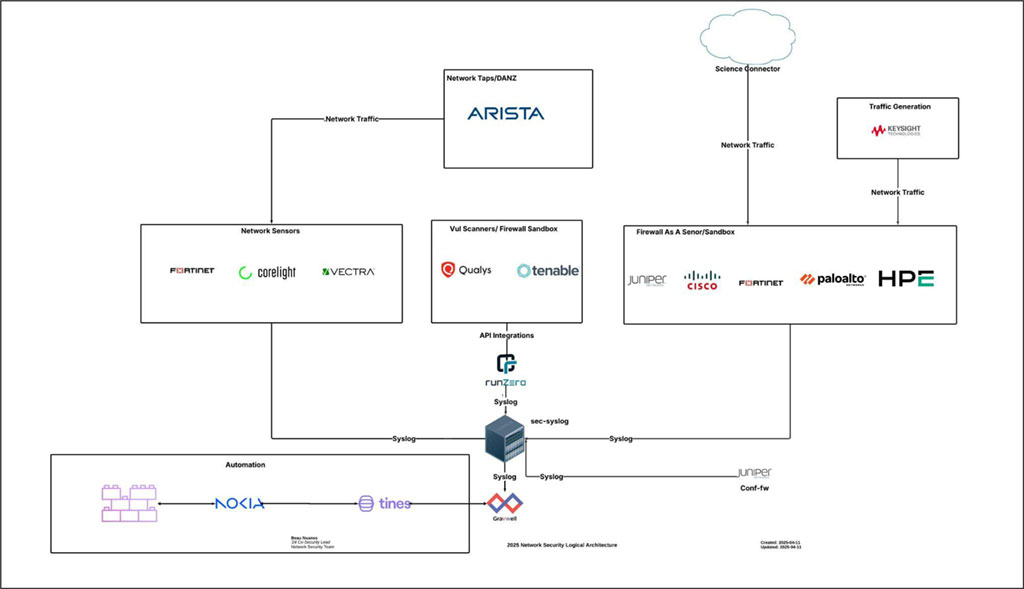

NetSec

Wykonanie tak dużej sieci wiąże się również z koniecznością odpowiedniego zabezpieczenia przed zagrożeniami oraz identyfikacji incydentów sieci.

Architekturę bezpieczeństwa sieci oparto na wielu warstwach zabezpieczeń, obejmujących m.in.:

- Stosowanie urządzeń klasy firewall do filtrowania ruchu

- Stosowanie network taps do zbierania kopii ruchu z wielu miejsc jednocześnie

- Stosowanie network sensors do wykrywania anomalii i incydentów

- Stosowanie Firewall Sandbox

Zastosowano rozwiązania sprzętowe (m.in.: Fortinet 4800F, Cisco 6160, Palo 7500) oraz rozwiązania programowe do rozbudowanej analityki (Gravwell, Qualys, Tenable).

Etapy budowy sieci

- 1 rok planowania

- 1 miesiąc budowy sieci

- 1 tydzień operacyjnego funkcjonowania

- 1 dzień na demontaż sieci

Prace nad architekturą nowej sieci rozpoczynają się na około rok przed kolejną edycją konferencji. W tym czasie zespół analizuje możliwości i ograniczenia infrastruktury centrum konferencyjnego, uzgadnia z producentami dostępność sprzętu oraz określa wymagania techniczne i zapotrzebowanie. Równolegle poszczególne zespoły projektują architekturę w swoich obszarach odpowiedzialności oraz przygotowują konfiguracje w wirtualnym laboratorium sieciowym, którego główna instancja utrzymywana jest w ICM Uniwersytetu Warszawskiego.

Na około miesiąc przed rozpoczęciem konferencji sprzęt dostarczany przez producentów trafia do tymczasowej lokalizacji, gdzie jest montowany w szafach rack. Dzięki zdalnemu dostępowi możliwe jest w tym okresie przenoszenie i testowanie konfiguracji na rzeczywistych urządzeniach. Około tydzień przed konferencją infrastruktura zostaje przeniesiona do docelowego centrum zarządzania siecią (NOC) oraz rozproszonych punktów DNOC. W trakcie operacyjnego działania sieci zespół koncentruje się na bieżącym rozwiązywaniu problemów oraz testowaniu wdrożonych rozwiązań w rzeczywistych warunkach. Po zakończeniu konferencji infrastruktura jest sprawnie demontowana i zwracana dostawcom sprzętu.

Podsumowanie

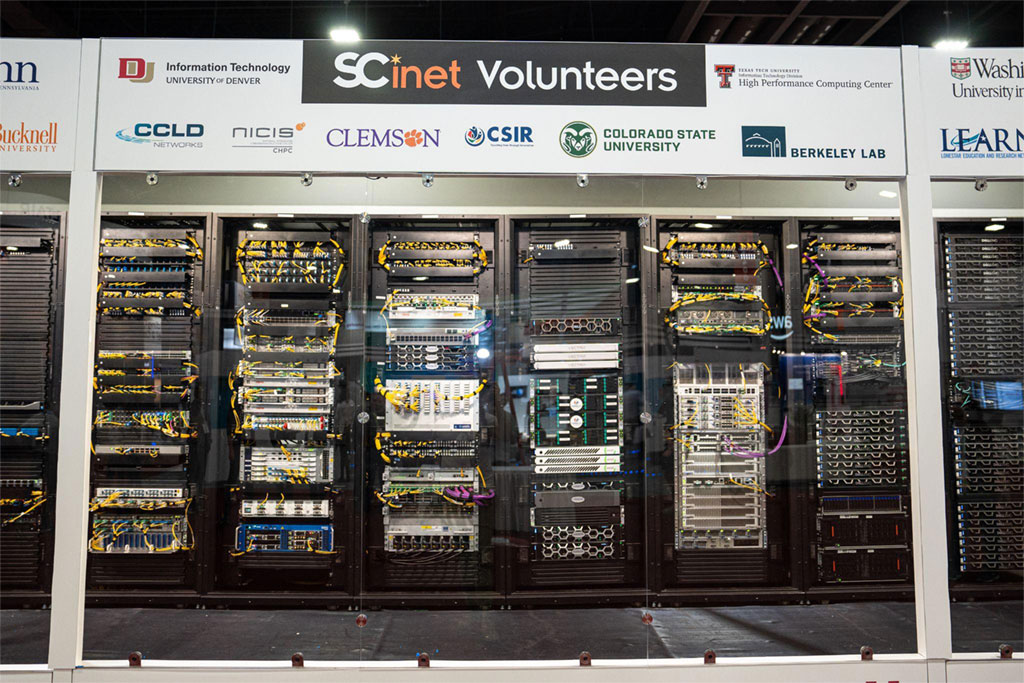

Zespół SCinet tworzy 215 specjalistów – wolontariuszy z ośmiu krajów, reprezentujących 128 instytucji: uczelni, agencji rządowych, ośrodków obliczeń dużej mocy, sieci badawczo-edukacyjnych i operatorów telekomunikacyjnych. Warto dodać, że częścią zespołu są również przedstawiciele producentów sprzętu i dostarczonych rozwiązań, co zapewnia szybkie wsparcie oraz sprawną diagnostykę sieci.

Tegoroczna edycja ponownie pobiła poprzednie rekordy przepustowości, a w ramach Network Research Exhibition uruchomiono 31 eksperymentów sieciowych. Do budowy SCinet wykorzystano sprzęt i usługi o łącznej wartości 70 mln USD. Dostawcy zaangażowani w projekt udostępnili swoje najnowsze platformy sprzętowe, które podczas konferencji przechodzą intensywne testy.

W tym roku szczególny nacisk położono na automatyzację procesów oraz interoperacyjność rozwiązań sieciowych. Z powodzeniem wykorzystano m.in. platformy Nautobot oraz Cisco NSO.

Członkowie zespołu SCinet wracają do swoich macierzystych instytucji z nową wiedzą i doświadczeniem zdobytym podczas projektowania i budowy sieci. Ten aspekt działalności SCinet jest niezwykle istotny – umożliwia wymianę spostrzeżeń, dobrych praktyk i wiedzy w przyjaznej, otwartej atmosferze.

Jarosław Skomiał, Bartosz Drogosiewicz